پاسخ سؤال وب اسکرپینگ چیست (Web Scraping)، در یک جمله خلاصه میشود: روشی برای استخراج خودکار دادههای عمومی از هر وبسایتی، مانند قیمت محصولات رقبا،اطلاعات تماس مشتریان بالقوه و…، آن هم بدون نیاز به نوشتن حتی یک خط کد. این تکنیک قدرتمند که زمانی فقط در اختیار غولهای تکنولوژی و برنامهنویسان حرفهای بود، امروز به لطف نرمافزارهای وب اسکرپینگ مدرن به ابزاری همگانی برای تصمیمگیری اصولی تبدیل شدهاست.

در این راهنمای کاربردی ما به شما نشان میدهیم که یک برنامه وب اسکرپینگ چیست، چگونه میتوانید با ابزارهای رایگان وب اسکرپینگ اولین پروژه خود را کلید بزنید، کاربردهای وب اسکرپینگ در دنیای واقعی چیست و چه زمانی باید به سراغ راهکارهای قدرتمندتری مانند وب اسکرپینگ با پایتون بروید.

فهرست مطالب

وب اسکرپینگ چگونه کار میکند؟

در فرایند وب اسکرپینگ، کدهای HTML یک صفحه وب را دریافت میکند، اطلاعات موردنظر را از دل آن بیرون میکشد و در یک فرمت ساختاریافته و قابلاستفاده مانند یک فایل اکسل (CSV)، JSON یا پایگاه داده ذخیره میکند. در واقع، برنامه وب اسکرپینگ، ظاهر یک وبسایت را که برای انسانها طراحی شده را به دادههای تمیز و دستهبندیشده برای تحلیل توسط ماشین تبدیل میکند.

فرایند وب اسکرپینگ در ۴ مرحله زیر اتفاق میافتد:

- ارسال درخواست (Request) به سرور وبسایت

- دریافت کد HTML صفحه

- تجزیه (Parsing) و استخراج دادههای مشخص

- ذخیرهسازی دادهها در فرمت ساختاریافته (مثل Excel)

فرق دادهکاوی (Data Mining) و API با وب اسکرپینگ

مفاهیم زیادی در علم داده وجود دارند که گاهی بهجای یکدیگر استفاده میشوند. اما یک متخصص تفاوتها را بهخوبی میداند. شاید این سؤال برایتان پیش آمده باشد که آیا وب اسکرپینگ همان دادهکاوی است؟ یا چرا به جای آن از API استفاده نکنیم؟

پاسخ شما در این جدول خلاصه شدهاست، اما در ادامه هم آنها را با یک مثال ساده باز میکنیم.

| ویژگی | وب اسکرپینگ (Web Scraping) | دادهکاوی (Data Mining) | رابط برنامهنویسی کاربردی (API) |

|---|---|---|---|

| هدف اصلی | جمعآوری داده از وب | کشف الگو و دانش از دادهها | دسترسی کنترلشده و مستقیم به داده |

| ماده اولیه | صفحات وب (HTML) | مجموعه دادههای بزرگ (Dataset) | نقاط پایانی (Endpoints) تعریفشده |

| خروجی | دادههای ساختاریافته (مثلاً جدول) | بینش، گزارش، مدلهای پیشبینی | داده خام در فرمت مشخص (JSON/XML) |

تفاوت Data Mining با وب اسکرپینگ چیست؟

در وب اسکرپینگ شما با ابزارهایی که دارید اطلاعات را از دریای وب جمعآوری میکنید بدون اینکه تحلیل خاصی درباره آنها داشته باشید. اما در دادهکاوی این اطلاعات بررسی میشوند و بنابه هدف، بهترینها جدا میشوند و یک بینش یا الگوی جدید خلق میشود.

به عبارت دیگر، وب اسکرپینگ معمولاً اولین قدم برای دادهکاوی است؛ ابتدا داده را جمع میکنیم، سپس آن را تحلیل میکنیم.

تفاوت API با وب اسکرپینگ چیست؟

در API (Application Programming Interface) شما یک درخواست مشخص (مثلاً «لیست قیمتها») را به سرور میدهید و سرور دقیقاً همان داده را در یک بستهبندی تمیز و آماده (معمولاً با فرمت JSON) به شما تحویل میدهد. این راهی رسمی، سریع و پایدار برای تبادل دادهاست.

ما معمولاً زمانی به سراغ وب اسکرپینگ میرویم که یک وبسایت، API عمومی ارائه نمیدهد یا API موجود، تمام دادههای موردنیاز ما (مثلاً نظرات کاربران که فقط روی صفحه نمایش داده میشوند) را پوشش نمیدهد.

کاربردهای وب اسکرپینگ با مثال

پساز شناخت web scraping میخواهیم ببینیم کاربردهای وب اسکرپینگ چیست و این تکنولوژی در عمل چه گرهی از کار کسبوکارها باز میکند.

۱- تحلیل قیمت و رصد رقبا در تجارت الکترونیک

یکی از رایجترین و قدرتمندترین کاربردهای وب اسکرپینگ است. فروشگاههای آنلاین میتوانند بهصورت خودکار و روزانه، قیمت محصولات، موجودی کالا، تخفیفها و کالاهای جدید رقبای خود را رصد کنند.

- مثال واقعی: یک فروشگاه آنلاین لوازم الکترونیکی را تصور کنید که با اسکرپ کردن روزانه قیمت گوشیهای موبایل از وبسایت رقبای اصلی خود، یک داشبورد تحلیلی ایجاد میکند. این دادهها به او کمک میکند استراتژی قیمتگذاری پویای خود را تنظیم کند، در کمپینها بهترین تخفیف را ارائه دهد و هیچگاه از بازار رقابتی عقب نماند.

۲- تولید سرنخهای فروش (Lead Generation) برای بازاریابی

پیدا کردن مشتریان بالقوه یکی از بزرگترین چالشهای تیمهای فروش و بازاریابی است. حتی ابزارهای رایگان وب اسکرپینگ میتوانند با استخراج اطلاعات تماس از منابع عمومی، این فرایند را تسریع کنند.

- مثال واقعی: یک شرکت نرمافزاری که محصولات خود را به سایر شرکتها (B2B) میفروشد، میتواند لیست شرکتهای حاضر در یک نمایشگاه صنعتی را از وبسایت همان نمایشگاه اسکرپ کند. این لیست که شامل نام شرکت، حوزه فعالیت و گاهی اطلاعات تماس است، یک منبع عالی برای تیم فروش جهت پیدا کردن سرنخهای جدید (Leads) محسوب میشود.

۳- تحقیقات بازار و تحلیل احساسات مشتریان

برای توسعه یک محصول موفق، باید بدانید مشتریان درباره شما و رقبایتان چه میگویند. وب اسکرپینگ به شما اجازه میدهد حجم عظیمی از نظرات، نقدها و بازخوردها را از وبسایتهای فروش، فرومها و شبکههای اجتماعی جمعآوری کنید.

- مثال واقعی: یک برند تولیدکننده لوازم آرایشی، نظرات کاربران درباره محصولات جدید خود و رقبایش را از وبسایتهای فروش و شبکههای اجتماعی جمعآوری میکند. سپس با تحلیل این نظرات (که به آن تحلیل احساسات یا Sentiment Analysis میگویند)، نقاط قوت و ضعف محصول خود را از دید مشتریان واقعی کشف میکند.

۴- جمعآوری دادههای عظیم برای پروژههای هوش مصنوعی

مدلهای هوش مصنوعی و یادگیری ماشین برای آموزش دیدن به حجم بسیار زیادی از داده نیاز دارند. وب اسکرپینگ یکی از اصلیترین روشها برای تأمین این «سوخت» اولیه است.

- مثال واقعی: یک تیم برنامهنویسی که درحال ساخت یک مدل هوش مصنوعی برای تشخیص تصاویر است، به هزاران عکس از یک شیء خاص (مثلاً خودرو) نیاز دارد. آنها میتوانند با برنامه وب اسکرپینگ، این تصاویر را از وبسایتهای فروش خودرو یا گالریهای آنلاین جمعآوری و برای آموزش مدل خود استفاده کنند.

۵- رصد لحظهای اخبار و مدیریت محتوا

وب اسکرپینگ به خبرگزاریها، تحلیلگران مالی و تیمهای روابط عمومی کمک میکند تا بهصورت لحظهای از آخرین اخبار و رویدادهای مرتبط با حوزه کاری خود مطلع شوند.

- مثال واقعی: یک تحلیلگر بازار سرمایه، تمام اخبار منتشرشده درباره شرکتهای بورسی را از خبرگزاریهای مختلف بهصورت لحظهای اسکرپ میکند. این کار به او کمک میکند تا قبلاز دیگران از رویدادهایی که بر قیمت سهام تأثیر میگذارند، مطلع شود و تصمیمات بهتری بگیرد.

خلاصه کاربردهای وب اسکرپینگ بهصورت جدول زیر است:

| حوزه کاربرد | چه دادهای استخراج میشود؟ | نتیجه برای کسبوکار |

|---|---|---|

| تجارت الکترونیک | قیمت، موجودی کالا، مشخصات محصولات رقبا | قیمتگذاری هوشمند و افزایش مزیت رقابتی |

| بازاریابی و فروش | اطلاعات تماس از دایرکتوریهای عمومی | افزایش سرنخهای فروش و کاهش هزینه جذب مشتری |

| تحقیقات بازار | نظرات، نقدها و بازخوردهای کاربران | درک عمیق از نیاز مشتری و بهبود محصول |

| هوش مصنوعی | تصاویر، متون، ویدئوها و هر نوع داده مرتبط | تأمین دادههای لازم برای آموزش مدلهای یادگیری ماشین |

| رصد اخبار | مقالات خبری، پستهای وبلاگ، اطلاعیههای مالی | تصمیمگیری سریع و آگاهانه براساس آخرین اطلاعات |

روشهای رایج برای وب اسکرپینگ

خوشبختانه برای استخراج داده از وب، تنها یک مسیر وجود ندارد. بسته به نیاز، پیچیدگی پروژه و مهارت فنی، میتوانید از ابزارهای مختلفی استفاده کنید. این روشها از ابزارهای کاملاً بصری و بدون نیاز به کدنویسی شروع میشوند و تا فریمورکهای قدرتمند برنامهنویسی ادامه پیدا میکنند.

روش اول: ابزارهای بدون کدنویسی (No-Code)

نرمافزارهای وب اسکرپینگ No-Code، برنامههایی با رابط کاربری گرافیکی (GUI) هستند که به شما اجازه میدهند تنها با کلیککردن روی عناصر یک صفحه وب به ربات آموزش دهید که چه دادههایی را استخراج کند.

فرایند کار با این ابزارها شبیه به آموزش دادن به یک دستیار است؛ شما وبسایت هدف را باز میکنید و به او میگویید: «اسم محصول اینجاست، قیمتش را از اینجا بردار و نظرات کاربران را از این قسمت کپی کن.» این ابزارها برای اکثر کارهای رایج، کاربردی هستند.

معرفی چند ابزار رایگان وب اسکرپینگ:

بازار پر از این ابزارهاست، اما بسیاری از آنها یک نسخه رایگان قدرتمند برای شروع ارائه میدهند:

۱- Octoparse

یک نرم افزار web scraping بسیار محبوب با قالبهای آماده برای سایتهای معروفی مثل آمازون و توییتر است. این ابزار میتواند فرایندهای پیچیدهای مانند لاگین کردن، جستجو و کلیک روی دکمه «صفحه بعد» را بهراحتی مدیریت کند.

۲- ParseHub

یکی دیگر از ابزارهای قدرتمند که بهخوبی از پسِ وبسایتهای پیچیده با جاوا اسکریپت، منوهای کشویی و نقشههای تعاملی برمیآید. نسخه رایگان آن برای پروژههای کوچک کاملاً مناسب است.

۳- Browse AI

این ابزار رویکرد جالبی دارد؛ شما کاری که میخواهید انجام شود را یکبار ضبط میکنید (Record) و Browse AI آن را به یک ربات اسکرپر تبدیل میکند. این روش برای کارهای تکراری بسیار سریع و کارآمد است.

روش دوم: افزونههای مرورگر (Browser Extensions)

افزونهها ابزارهای سبک و سادهای هستند که مستقیماً روی مرورگر شما (مانند کروم یا فایرفاکس) نصب میشوند. این افزونهها برای کارهای سریع و پروژههای کوچکمقیاس که نیازی به تنظیمات پیچیده ندارند فوقالعادهاند.

- مثال: افزونه محبوب Web Scraper.io به شما اجازه میدهد در همان صفحهای که درحال مشاهده آن هستید، یک «نقشه سایت» (Sitemap) برای استخراج داده تعریف کنید و با یک کلیک، اطلاعات را جمعآوری و در قالب CSV دانلود کنید.

روش سوم: وب اسکرپینگ با پایتون (برای حرفهایها)

وقتی ابزارهای آماده دیگر پاسخگوی نیازهای پیچیده شما نیستند یا به انعطافپذیری و کنترل کامل بر فرایند نیاز دارید، زمان استفاده از کدنویسی فرا میرسد. زبان برنامهنویسی پایتون به لطف کتابخانههای قدرتمندش به پُرکاربردترین ابزارها برای وب اسکرپینگ تبدیل شدهاست.

- BeautifulSoup: این کتابخانه، همانطور که در آموزشهای Real Python آمده، یک ابزار بینظیر برای تجزیه (Parsing) کدهای HTML و XML است. BeautifulSoup به شما کمک میکند تا اطلاعات موردنظرتان را بادقت از دل کدهای پیچیده یک صفحه وب بیرون بکشید.

- Scrapy: اگر BeautifulSoup مجموعهای از ابزارهای جراحی باشد، Scrapy یک اتاق عمل کامل و مجهز است. Scrapy یک فریمورک جامع است که تمام مراحل وب اسکرپینگ، از ارسال درخواستها بهصورت همزمان تا مدیریت دادهها و ذخیرهسازی آنها را پوشش میدهد. این ابزار برای پروژههای عظیم و صنعتی طراحی شدهاست.

در جدول زیر روشهای وب اسکرپینگ را مقایسه کردهایم:

| روش | سطح دشواری | بهترین کاربرد | مثال ابزار |

|---|---|---|---|

| ابزارهای No-Code | آسان | پروژههای کوچک تا نیمهبزرگ، شروع سریع | Octoparse, ParseHub |

| افزونههای مرورگر | بسیار آسان | استخراج سریع داده از یک یا چند صفحه ساده | Web Scraper.io |

| برنامهنویسی (پایتون) | دشوار | پروژههای بزرگ، پیچیده و کاملاً سفارشی | Scrapy, BeautifulSoup |

نحوه جمعآوری دادهها بدون کدنویسی با وب اسکرپینگ

خب فکر میکنم صحبت کردن درباره اینکه وب اسکرپینگ چیست و چه ابزارهایی دارد، تا وقتی که یک پروژه عملی وجود نداشته باشد به درد ما نمیخورد؛ چون هیچچیز نمیتواند جای یک پروژه عملی را بگیرد. هدف این بخش این است که به شما ثابت کنیم فرایند استخراج داده با ابزارهای مدرن چقدر سادهتر از چیزی است که فکر میکنید. برای این کار از منطق ابزارهای No-Code مانند Octoparse استفاده میکنیم.

سناریوی ما: استخراج لیست لپتاپها از یک فروشگاه آنلاین

فرض کنید میخواهیم برای تحلیل بازار، لیستی از لپتاپهای موجود در یک وبسایت فروشگاهی بزرگ را به همراه قیمت و امتیازشان استخراج کنیم. دادههایی که بهدنبال آن هستیم عبارتاند از:

- نام مدل لپتاپ

- قیمت

- امتیاز کاربران (در صورت وجود)

گام اول: انتخاب ابزار و وارد کردن URL

ابتدا یک ابزار رایگان وب اسکرپینگ (مانند Octoparse یا ParseHub) را باز میکنیم و URL صفحهای که لیست لپتاپها در آن قرار دارد را در قسمت ورودی برنامه کپی میکنیم. سپس روی دکمه «Start» کلیک میکنیم. ابزار صفحه وب را در محیط داخلی خود بارگذاری میکند.

گام دوم: آموزش به ربات برای شناسایی دادهها

این جذابترین بخش کار است. حالا باید به ربات یاد بدهیم که چه اطلاعاتی را میخواهیم.

- انتخاب دادهها: روی نام اولین لپتاپ در لیست کلیک میکنیم. ابزار به صورت هوشمند تمام موارد مشابه (یعنی نام سایر لپتاپها) را در صفحه شناسایی کرده و هایلایت میکند. ما این فیلد داده را «نام محصول» ذخیره میکنیم.

- تکرار برای سایر اطلاعات: همین کار را برای قیمت و امتیاز کاربران نیز تکرار میکنیم. روی قیمت اولین محصول کلیک و آن را بهعنوان فیلد «قیمت» ذخیره میکنیم.

ابزار یک پیشنمایش از دادههای استخراجشده را در پایین صفحه به شما نشان میدهد.

گام سوم: مدیریت صفحات متعدد (Pagination)

معمولاً لیست محصولات در چندین صفحه قرار دارد. باید به ربات یاد بدهیم که پساز تمام شدن صفحه اول به صفحات بعدی برود. برای این کار به پایین صفحه اسکرول و روی دکمه «صفحه بعد» یا شماره «2» کلیک میکنیم.

سپس از منوی بازشده، گزینه «Loop click the next page button» (روی دکمه «صفحه بعد کلیک کن و این کار را تکرار کن») را انتخاب میکنیم. به همین سادگی، ربات یاد میگیرد که تمام صفحات را یکییکی مرور کند.

گام چهارم: اجرا، استخراج و دریافت خروجی

حالا که ربات آموزش دیدهاست، کافی است روی دکمه «Run» یا «Start Scraping» کلیک کنیم. ابزار شروع به کار میکند و تمام مراحلی که به او یاد دادهایم را بهصورت خودکار بهاجرا درمیآورد. مثلاً به صفحه میرود، دادهها را استخراج میکند، به صفحه بعد میرود و این کار را تا انتها ادامه میدهد. پساز چند دقیقه، تمام دادهها بهصورت مرتب در یک جدول جمعآوری میشوند و شما میتوانید آن را با فرمت دلخواه، مانند CSV یا Excel دانلود کنید.

تمام شد! شما همین الان اولین پروژه وب اسکرپینگ خود را بدون نوشتن حتی یک خط کد با موفقیت انجام دادید. این قدرت ابزارهای مدرن است که تحلیل داده را برای همه دسترسپذیر میکند.

مشکلات رایج وب اسکرپینگ و راهحلها

شما اولین پروژه خود را با یک نرم افزار وب اسکرپینگ اجرا میکنید و همه چیز عالی پیش میرود. دادهها بهسرعت در حال جمعآوری هستند… تا اینکه ناگهان با یک خطای عجیب، یک صفحه خالی یا یک کپچای مزاحم روبرو میشوید. به دنیای واقعی وب اسکرپینگ خوش آمدید! استخراج داده همیشه یک مسیر هموار نیست، اما خبر خوب این است که تمام این مشکلات، راهحلهای شناختهشدهای دارند.

در ادامه به ۴ چالش رایج که هر متخصصی با آن روبرو میشود میپردازیم.

۱. مسدود شدن (IP Blocking)

مشکل چیست؟ این رایجترین چالش است. وبسایتها طوری طراحی شدهاند که درخواستهای متعدد و سریع از یک آدرس IP واحد را بهعنوان یک ربات متخاصم شناسایی و آن IP را مسدود میکنند. در نتیجه، شما دیگر به وبسایت دسترسی نخواهید داشت.

راهحلها:

- استفاده از پراکسیهای چرخشی (Rotating Proxies): بهجای ارسال تمام درخواستها از IP خودتان، از سرویسهای پراکسی استفاده کنید که هر درخواست را ازطریق یک IP متفاوت ارسال میکنند. این کار شناسایی ربات شما را برای سرور بسیار دشوار میکند.

- تنظیم سرعت (Rate Limiting): بهجای ارسال صدها درخواست در یک ثانیه، بین هر درخواست یک تأخیر زمانی تصادفی (مثلاً بین ۲ تا ۷ ثانیه) قرار دهید. این کار رفتار اسکرپر شما را به یک انسان شبیهتر میکند.

- تغییر User-Agent: مرورگر شما هنگام ارسال درخواست، خود را با یک رشته به نام User-Agent معرفی میکند (مثلاً Chrome on Windows). اسکرپرها هم همینطور. همیشه User-Agent ربات خود را در هر درخواست تغییر دهید تا ردپای کمتری از خود به جا بگذارید.

۲. وبسایتهای داینامیک و محتوای مبتنی بر جاوا اسکریپت

مشکل چیست؟ بسیاری از وبسایتهای مدرن، محتوای خود را بلافاصله در کد HTML اولیه بارگذاری نمیکنند. در عوض، پساز بارگذاری صفحه، جاوا اسکریپت اطلاعات را از سرور دیگری دریافت و در صفحه نمایش میدهد (مانند لیست نظرات کاربران که با اسکرول کردن بارگذاری میشود). اسکرپرهای ساده که فقط کد HTML اولیه را میخوانند، یک صفحه خالی میبینند.

راهحلها:

- استفاده از مرورگرهای Headless: در پروژههای وب اسکرپینگ با پایتون، میتوان از ابزارهایی مانند Selenium یا Playwright استفاده کرد. این ابزارها یک مرورگر واقعی (مثلاً کروم) را در پسزمینه اجرا میکنند، منتظر میمانند تا تمام جاوا اسکریپتها اجرا و محتوا کامل بارگذاری شود و سپس کد نهایی صفحه را برای استخراج در اختیار شما قرار میدهند.

- استفاده از نرمافزارهای پیشرفته: بسیاری از ابزارهای رایگان وب اسکرپینگ مانند ParseHub یا Octoparse، قابلیت مدیریت وبسایتهای داینامیک را بهصورت داخلی دارند و این پیچیدگی را از دوش شما برمیدارند.

۳. تغییر ساختار وبسایت

مشکل چیست؟ شما یک اسکرپر بینقص طراحی میکنید که ماهها بهخوبی کار میکند. یک روز صبح متوجه میشوید که دیگر هیچ دادهای استخراج نمیشود. دلیلش این است که تیم طراحی وبسایت، ساختار کدنویسی صفحه (مثلاً نام کلاس CSS قیمت محصول) را تغییر داده و ربات شما دیگر نمیتواند مسیر دادهها را پیدا کند.

راهحلها:

- انتخابگرهای (Selectors) پایدار بنویسید: بهجای اتکا به کلاسهای CSS که ممکن است زیاد تغییر کنند (مانند class=”product-price-_xs-2-b”), سعی کنید از شناسههای پایدارتر مانند IDها یا ساختار کلی HTML برای پیدا کردن عناصر استفاده کنید.

- راهاندازی سیستم هشدار: یک اسکریپت مانیتورینگ ساده بنویسید که اگر خروجی اسکرپر شما خالی بود یا تعداد رکوردهای استخراجشده بهطور ناگهانی کاهش یافت به شما یک ایمیل هشدار ارسال کند.

۴. کپچاهای مزاحم (CAPTCHA)

مشکل چیست؟ کپچاها (تستهای تشخیص انسان از ربات) مشخصاً برای متوقف کردن رباتها، از جمله اسکرپرها، طراحی شدهاند.

راهحلها:

- سرویسهای حل کپچا: شرکتهای شخص ثالثی وجود دارند که با استفاده از هوش مصنوعی یا نیروی انسانی، کپچاها را برای شما حل میکنند. شما تصویر کپچا را به API آنها ارسال میکنید و متن حلشده را دریافت میکنید. این روش معمولاً هزینه دارد و پیچیدگی پروژه را افزایش میدهد.

- پیشگیری بهتر از درمان است: بهترین راه برای روبرو نشدن با کپچا، این است که از ابتدا با رعایت اصول اسکرپینگ اخلاقی (سرعت پایین، استفاده از پراکسی باکیفیت و تغییر User-Agent)، کاری نکنید که وبسایت به شما مشکوک شود.

غلبه بر این چالشها، مرز بین یک پروژه وب اسکرپینگ آماتور و یک سیستم حرفهای استخراج داده را مشخص میکند.

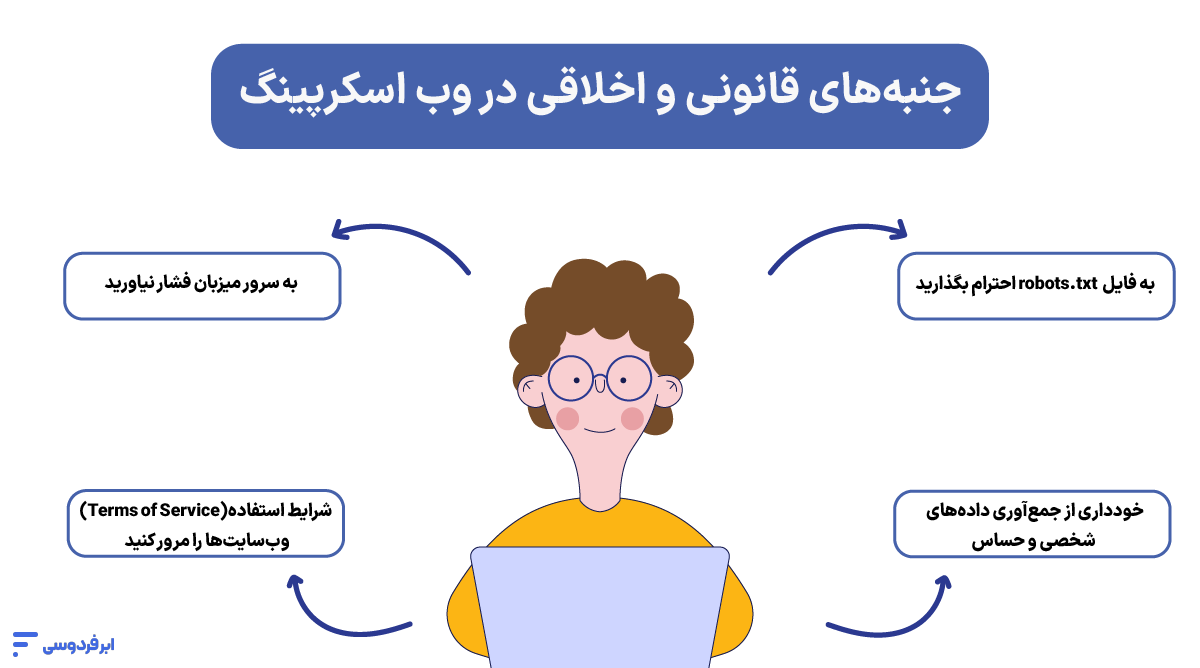

جنبههای قانونی و اخلاقی در وب اسکرپینگ چیست؟

وب اسکرپینگ ابزاری فوقالعاده قدرتمند است و مانند هر ابزار قدرتمند دیگری، استفاده از آن نیازمند رعایت مجموعهای از قوانین و اصول اخلاقی است که رعایت نکردن آنها ممکن است باعث بروز مشکلات قانونی برای شما شود. اما ببینیم منظور از این ملاحظات اخلاقی در وب اسکرپینگ چیستند.

نکته مهم: این بخش یک راهنمای کلی برای اسکرپینگ اخلاقمحور است و نباید بهعنوان مشاوره حقوقی درنظر گرفته شود. همیشه قوانین و شرایط استفاده وبسایتها را بهدقت بررسی کنید.

۱- به فایل robots.txt احترام بگذارید

فایل robots.txt یک فایل متنی ساده است که در ریشه (root) اکثر وبسایتها قرار دارد (مثلاً example.com/robots.txt). این فایل مانند یک تابلو راهنما برای رباتها و اسکرپرها عمل میکند و به آنها میگوید که اجازه بازدید از کدام بخشهای وبسایت را دارند و کدام بخشها ممنوعه هستند.

- چرا مهم است؟ احترام به این فایل، اولین اصل ادب دیجیتال است. اگرچه ازنظر فنی میتوانید این قوانین را نادیده بگیرید، اما انجام این کار نشانه بیاحترامی به صاحب وبسایت است و معمولاً اولین قدم برای قرارگرفتن در لیست سیاه (Blacklist) خواهد بود.

۲- شرایط استفاده (Terms of Service) وبسایتها را مرور کنید

سند «شرایط استفاده» یا «Terms of Service» (ToS) قراردادی است که شما با استفاده از یک وبسایت با آن موافقت میکنید. بسیاری از وبسایتها در این سند به صراحت، هرگونه دسترسی خودکار یا جمعآوری داده از طریق اسکرپینگ را ممنوع اعلام کردهاند.

- چرا مهم است؟ نقض کردن ToS میتواند به وبسایت این حق را بدهد که دسترسی شما را مسدود کند. همیشه قبلاز شروع یک پروژه بزرگ، این سند را برای کلماتی مانند “scraping”، “automated access” یا “bots” جستجو کنید.

۳- از جمعآوری دادههای شخصی و حساس خودداری کنید

این مهمترین خط قرمز اخلاقی و قانونی است. هرگز دادههایی را که میتوانند برای شناسایی یک فرد خاص استفاده شوند (مانند نام، آدرس ایمیل، شماره تلفن، یا اطلاعات خصوصی پروفایلها) جمعآوری نکنید، مگر اینکه رضایت صریح آنها را داشته باشید.

- چرا مهم است؟ جمعآوری و پردازش دادههای شخصی بدون اجازه، نقض حریم خصوصی افراد است و تحت قوانین سختگیرانهای مانند GDPR در اروپا قرار میگیرد. همیشه روی دادههای عمومی و غیرشخصی تمرکز کنید.

۴- به سرور میزبان فشار نیاورید (با سرعت معقول درخواست ارسال کنید)

یک اسکرپر غیرحرفهای میتواند در یک ثانیه، صدها درخواست به سمت یک وبسایت ارسال کند. این کار مانند این است که صدها نفر بهطور همزمان بخواهند از یک در کوچک وارد شوند؛ نتیجه آن کند شدن یا ازکارافتادن وبسایت برای کاربران واقعی است.

- چرا مهم است؟ این عمل علاوهبر اینکه غیراخلاقی است، سریعترین راه برای شناسایی شدن و مسدود شدن دائمی IP شماست. همیشه بین درخواستهای خود یک تأخیر منطقی (مثلاً ۱ تا ۵ ثانیه) قرار دهید تا رفتار شما به یک کاربر انسانی شبیهتر باشد.

رعایت این نکته و استفاده از تکنیکهای دیگر، کلید اصلی جلوگیری از مسدودشدن است. برای اطلاعات بیشتر در این زمینه، حتماً راهنمای کامل ما درباره تکنیکهای جلوگیری از بلاک شدن در وب اسکرپینگ را مطالعه کنید.

نکات پیشرفته وب اسکرپینگ حرفهای

تا اینجا یاد گرفتیم که وب اسکرپینگ چیست و چگونه با ابزارهای آماده، اولین پروژههای خود را اجرا کنیم. این روش برای کارهای کوچک و یکباره فوقالعاده است. اما وقتی تصمیم میگیرید یک پروژه را به سطح حرفهای و صنعتی برسانید، با چالشهایی روبرو میشوید که نیازمند یک زیرساخت کاملاً متفاوت است. در ادامه ۴ اصل کلیدی برای اجرای پروژههای بزرگ را بررسی میکنیم.

۱. اجرای بدون وقفه

یک پروژه حرفهای رصد قیمت یا جمعآوری اخبار، نباید با خاموش شدن لپتاپ شما متوقف شود. این اسکرپرها باید به صورت ۲۴ ساعته و ۷ روز هفته درحال اجرا باشند تا هیچ دادهای را از دست ندهند. روشن نگه داشتن کامپیوتر شخصی برای این کار، نه ممکن است و نه به صرفه.

۲. مدیریت IP و اثر انگشت دیجیتال

وقتی حجم درخواستهای شما بالا میرود، IP اینترنت خانگی شما به سرعت شناسایی و مسدود میشود. پروژههای حرفهای به IPهای تمیز و اختصاصی (Dedicated) نیاز دارند که از شبکه خانگی شما جدا باشند. این کار مدیریت فرآیند جلوگیری از مسدودشدن را بسیار آسانتر میکند.

۳. نیاز به قدرت پردازشی اختصاصی

اجرای یک اسکرپر پیچیده، بهخصوص اگر از مرورگرهای Headless برای سایتهای داینامیک استفاده کند، میتواند تمام منابع CPU و RAM کامپیوتر شما را مصرف کند. یک پروژه حرفهای نباید سیستم شخصی شما را کند یا درگیر کند؛ بلکه به منابع پردازشی اختصاصی خود نیاز دارد.

۴. امنیت و پایداری دادهها

فرض کنید درحین یک فرایند استخراج چند ساعته، اینترنت شما قطع شود. تمام دادههای جمعآوری شده ممکن است ازبین بروند. پروژههای بزرگ به یک محیط پایدار با اینترنت و برق دائمی نیاز دارند تا امنیت و یکپارچگی دادههای ارزشمند شما تضمین شود.

سرور مجازی (VPS) راهحل همه اینها است

همانطور که میبینید، تمام این نکات حرفهای در یک نقطه به هم میرسند: شما به یک زیرساخت اختصاصی، قدرتمند و همیشه آنلاین برای اسکرپر خود نیاز دارید. تنها زیرساختی که میتوانید این امکانات را در اختیار شما قرار دهد سرور مجازی (VPS) است.

اگر با مفهوم سرور مجازی آشنایی چندانی ندارید، در مقاله زیر میتوانید اطلاعات دقیق و کاربردی درباره این موضوع جمعآوری کنید.

یک سرور مجازی تمام این نیازها را در یک بسته کامل برآورده میکند:

- یک کامپیوتر همیشه روشن دارید که میتوانید اسکریپت خود را روی آن اجرا کنید و لپتاپ خود را با خیال راحت خاموش کنید.

- منابع پردازشی اختصاصی در اختیار شما قرار میدهد تا پروژههای سنگین را با سرعت بالا اجرا کنید.

- یک IP تمیز و اختصاصی در اختیار شما میگذارد که مدیریت آن برای جلوگیری از بلاک شدن آسانتر است.

- در دیتاسنتری امن و پایدار قرار دارد که نگران قطعی اینترنت یا برق آن نخواهید بود.

سرورهای مجازی ابر فردوسی امکانات زیر را برای اجرای پروژههای وب اسکرپینگ در اختیار شما قرار میدهند:

- یک کامپیوتر همیشه روشن دارید که میتوانید اسکریپت اسکرپینگ خود را روی آن اجرا کنید، از سیستم خارج شوید و با خیال راحت لپتاپ خود را خاموش کنید.

- منابع پردازشی اختصاصی و قابلتغییر در اختیار شما قرار میدهد؛ یعنی میتوانید پروژههای سنگینتر را با سرعتی بسیار بالاتر اجرا کنید، بدون آنکه نگران کند شدن سیستم شخصی خود باشید.

- یک IP تمیز در اختیار شما قرا رمیدهد که از شبکه خانگی جدا است و مدیریت آن برای جلوگیری از بلاک شدن بسیار آسانتر است.

- دیتاسنتری با بالاترین درجه امنیتی دارید که در آن فرایند اسکرپینگ شما بهدلیل قطعی اینترنت یا برق متوقف نمیشود و هم دادههای شما در محیطی امنتر ذخیره میشوند.

شما میتوانید با ۱۰۰ هزار تومان اعتبار رایگان، اولین سرور مجازی خود را در ابر فردوسی بسازید و پروژههای بزرگ خود را در کمترین زمان شروع کنید.

جمعبندی

در این راهنما بهطور کامل توضیح دادیم که وب اسکرپینگ چیست، چه تفاوتی با دادهکاوی و API دارد، و چگونه میتوان با استفاده از ابزارهای مدرن، حتی بدون نیاز به کدنویسی، دادههای ارزشمند را از وب استخراج کرد. این مهارت، چه برای تحلیل رقبا، چه برای تحقیقات بازار یا پروژههای هوش مصنوعی، یک مزیت رقابتی بزرگ محسوب میشود. مهمتر از همه، شما با جنبههای قانونی و اخلاقی این کار نیز آشنا شدید تا پروژههای خود را بهصورت مسئولانه انجام دهید.

اولین پروژهای که دوست دارید با وب اسکرپینگ انجام دهید چیست؟ آیا ابزار No-Code دیگری میشناسید که تجربه کار با آن را داشته باشید؟ دیدگاههای خود را در بخش نظرات با ما به اشتراک بگذارید.

سؤالات متداول

web scraping چیست؟

فرایند استخراج خودکار اطلاعات از صفحات وبسایتها و ذخیره آنها در یک فرمت ساختاریافته و قابلاستفاده (مانند فایل اکسل) است. این کار توسط رباتهای نرمافزاری به نام «اسکرپر» انجام میشود.

آیا وب اسکرپینگ قانونی است؟

بهطور کلی، استخراج دادههای عمومی که مشمول کپیرایت نیستند، قانونی تلقی میشود. بااینحال، برای اینکه همیشه در سمت امن ماجرا باشید، باید به فایل robots.txt و «شرایط استفاده» وبسایتها احترام بگذارید و هرگز دادههای شخصی و حساس را جمعآوری نکنید.

آیا برای وب اسکرپینگ باید برنامهنویس باشم؟

خیر! امروزه ابزارهای بدون کدنویسی (No-Code) قدرتمندی مانند Octoparse و ParseHub وجود دارند که به شما اجازه میدهند تنها با کلیک کردن و بدون نوشتن حتی یک خط کد، پروژههای وب اسکرپینگ را اجرا کنید.

تفاوت اصلی وب اسکرپینگ و API چیست؟

API یک راه رسمی و کنترلشده است که صاحب وبسایت برای دسترسی به دادههایش در اختیار شما قرار میدهد (مانند سفارش از منوی رستوران). اما وب اسکرپینگ زمانی استفاده میشود که API وجود ندارد و شما دادهها را مستقیماً از ظاهر صفحه استخراج میکنید.

بهترین نرم افزار وب اسکرپینگ چیست؟

«بهترین» نرمافزار به نیاز شما بستگی دارد. برای مبتدیان و پروژههای معمولی، ابزارهای No-Code مانند Octoparse و Browse AI گزینههای عالی هستند. برای پروژههای بزرگ و سفارشی، فریمورک پایتون یعنی Scrapy ابزارهای استاندارد محسوب میشود.

چرا ممکن است هنگام وب اسکرپینگ بلاک شوم؟

دو دلیل اصلی برای بلاک شدن وجود دارد: ۱) ارسال درخواست با سرعت بیشازحد که باعث فشار روی سرور میزبان میشود و ۲) نادیده گرفتن قوانین وبسایت که در فایل robots.txt یا شرایط استفاده مشخص شدهاند.